Carlos Chimal

Como nunca antes, la metáfora de la computadora como esencia de nuestra naturaleza animal opaca las verdaderas distinciones entre animales, humanos y máquinas. No deja de ser irónico que hoy en día los artefactos “inteligentes” nos exijan demostraciones fehacientes de que no son meros robots.

En el fondo de este concepto que ha adquirido importancia en los últimos treinta años se encuentra el círculo vicioso/virtuoso entre animales, máquinas y humanos. Sin embargo, su incidencia en la literatura no comenzó sino hasta 2016, cuando un grupo de investigadores del Laboratorio Computacional de la Universidad de Vermont publicó un estudio en el que afirmaba que la mayoría de los libros se construyen únicamente a partir de seis arcos emocionales. Antes de hablar de ello, pongamos en contexto histórico dicha relación animal-humano-máquina, sobre todo a partir del siglo XVIII, que desembocó en el nacimiento de la cibernética y más tarde en la inteligencia artificial (IA).

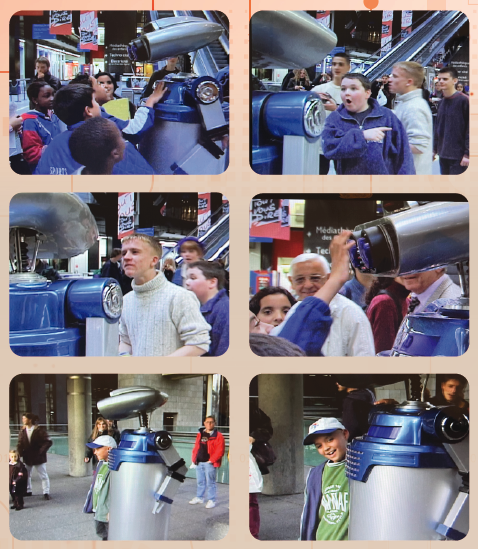

Corre el año de 1999. El robot Félix, manipulado por sus creadores a distancia, sorprende a los asistentes al Museo de Ciencias de La Villette, en París, durante su acostumbrado recorrido de los viernes por la tarde, pues responde a sus preguntas con inusitada soltura, no obstante su apariencia, como si hubiera salido de una película de los cincuentas. Es rígido, no es capaz de girar y ni siquiera gesticula, pero mediante un par de artilugios simples (distorsión de la voz y control remoto) el público está dispuesto a creer que se ha topado con un artefacto inteligente.

Desde entonces se han hecho progresos enormes en materia de robótica e IA. Hoy nos dan lecciones de pintura, exhiben virtuosismo musical y talento literario, son impacables asesores en la toma de decisiones. Según el matemático Alan Turing propuso en 1950, alrededor del año 2000 ya existiría una máquina que, al cabo de cinco minutos de interrogarla, quien formula las preguntas no podría decidir si se trata de un humano o no.

Una nueva época, posterior al modernismo, daría inicio. El pronóstico de Turing se cumplió poco después, pues en ciertas situaciones existen programas cuyo propósito es la deducción mediante el diálogo, a través de juegos de palabras e intenciones. En 2010, Suzette, robot inventado por Bruce Wilcox, superó dicha prueba. En 2014 otro ingenio robótico, llamado Eugene Goostman, pudo convencer al tercio de un jurado de que se trataba de un joven ucraniano.

Ya se ha superado el primer intento por crear las bases de la IA, dotando a una computadora de reglas almacenadas en una memoria, así como de una red de elementos independientes que involucran símbolos y dispositivos de percepción y aprendizaje con base en la experiencia, como si le enseñáramos a un bebé a dar sus primeros pasos. Hoy estamos ingresando en el terreno ignoto, hipermoderno, de la inteligencia artificial general (IAG). A diferencia de la IA tradicional, de enfoque débil, cuyo propósito se limita a explicar los mecanismos que subyacen en el comportamiento de animales y humanos, la IAG, de enfoque fuerte, declara, sin ningún recato, su decidida intención de crear no solo máquinas inteligentes, emotivas, con criterio, sino transhumanos y extropianos.

Sus defensores suponen que el pensamiento y otras características mentales no están unidos de manera indisoluble al cuerpo original, por lo que pretenden generar la posibilidad de perpetuar nuestra vida mental en una plataforma más robusta y longeva que nuestros efímeros organismos biológicos. Sin embargo, el pensamiento mecanizable no ha podido transmitirse cabalmente a un robot porque éste carece de funciones nerviosas.

Y he ahí que, a manera de rizomas, asoman vertientes, matices, senderos que hacen de la IA una hiperciencia, compleja, nutrida por las más dispares disciplinas. En el sinuoso camino recorrido se ha servido de diversas metáforas: los organismos vivos como máquinas; la inteligencia como una computadora, como un ente cibernético; la mente como una jugadora en el certamen de la supervivencia. En el fondo, su propósito es cerrar el círculo animal-humano-máquina.

El estudio detallado del sistema nervioso, sobre todo a partir de las investigaciones de Santiago Ramón y Cajal, a principios del siglo XX, condujo tres décadas después a una crucial síntesis entre lo que se sabía de los mecanismos de transmisión neuronal y determinados conceptos matemáticos, gracias al insólito diálogo entre el neurofisiólogo Arturo Rosenblueth y el matemático Norbert Wiener.

Concluyeron que todo comportamiento inteligente es consecuencia de determinados mecanismos de retroalimentación, los cuales nos otorgan experiencia. La inteligencia no es más que el resultado de adquirir información y procesarla, de retroalimentar el sistema de manera adecuada para un fin. En 1955, la cibernética, en la que se reunieron otras grandes disciplinas ya establecidas, algunas milenarias, como el diseño y construcción de ingenios mecanizados, incluía problemas inéditos como la retroalimentación entre un organismo vivo y una máquina.

Provocó cambios drásticos a escala mundial durante la segunda mitad del siglo XX, pues las investigaciones en neurociencias demostraron que había una similitud entre las fibras nerviosas y los modelos eléctricos, entre el cerebro humano y las máquinas calculadoras. La interiorización dentro de la célula y dentro de los átomos también causó un auge en la posibilidad de crear ciborgs, mitad humano y mitad artificio.

Las propuestas cibernéticas empujaron las ideas milenarias de dotar de inteligencia a las máquinas. Pero, ¿cómo debía procederse? ¿Había que ir de arriba hacia abajo, construir primero un cerebro, lo más complejo posible, para luego dotarlo de movilidad, enseñarle a moverse y realizar tareas específicas? O bien, por el contrario, ir de abajo hacia arriba. ¿Era necesario primero construir partes simples, las cuales, con el tiempo y la interacción, evolucionarían y proporcionarían propiedades emergentes, encaminadas a crear entidades inteligentes y sensibles, autónomas y emprendedoras?

Se han inventado ollas que cocinan de manera impecable el arroz al vapor, como les gusta a los japoneses tradicionales. Nuevos diseñadores y programadores, inspirados en dicha olla, se han lanzado a la tarea de ofrecernos un asesor culinario casero dotado de IA.

Pero no es suficiente para llamarlo “inteligente”. Aun así, la IA se está expandiendo hacia una gama muy diversa de las actividades económicas, políticas, militares, artísticas y sociales en nuestros días.

El filósofo John Searle ponía en duda el que la máquina de Turing fuese capaz de engañar sobre su verdadera identidad, y, por tanto, ser una máquina pensante. No lo es en realidad porque en el fondo solo sigue manipulando símbolos, ajenos a su voluntad, y es totalmente dependiente del humano que la ha programado. Su consistencia es artificial, simulada. Aun así, muchos investigadores y compañías fabrican entes cibernéticos con posibilidad de adquirir criterio. El obstáculo es alto, pues el criterio está restringido a organismos biológicos que muestran discernimiento por experiencia propia o adquirida mediante cultura (transmisión de datos valiosos) ante eventos de la realidad cambiante. No es suficiente que un robot, al que solamente se le ha dotado de cabeza, haga una mueca de dolor y desagrado ante un impulso eléctrico agresivo.

Marvin Minsky, también filósofo, aplicó sus conocimientos de óptica, neurociencias y psicología para tratar de construir su propio modelo de cerebro cibernético. Privilegiando la metáfora del ser humano como un mero ordenador sofisticado, hace hincapié en el papel activo de la mente, es decir, el cerebro como procesador de información más que como mero mecanismo pasivo de asociación. Y para ello es esencial conocer, estar dotado de procesos cognitivos a fin de descifrar, de “jugar” contra el contrincante perenne: la realidad cambiante. Qué duda cabe de que el mundo en que vivimos es una especie de juego de ajedrez cuasi-infinito, en donde el número de posibilidades factibles en la vida diaria son tantas que nos resulta imposible hacer planes con buena antelación. Las máquinas que juegan ajedrez son dependientes del conocimiento que se les ha agregado en forma de códigos, lo mismo que animales y humanos, pues la única oportunidad de sobrevivir en un entorno complejo reside en nuestra carga cognoscitiva. Pero conocer es pensar.

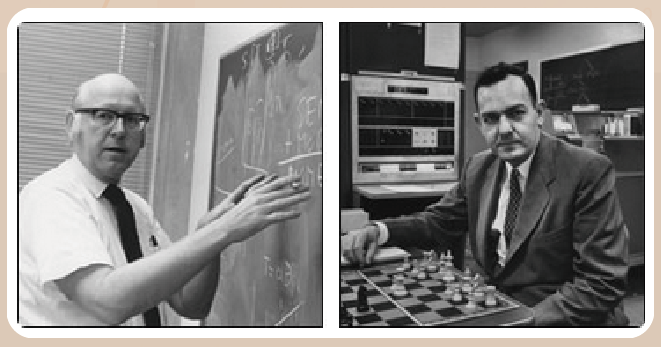

Tradicionalmente, el pensamiento se considera, sobre todo, un cálculo basado en el razonamiento lógico. Tomás Hobbes (1588-1679) estaba convencido de que, al razonar, no hacíamos otra cosa que sumar parcelas, manipular unidades básicas en términos sintácticos, idea que recogió Gottfried Leibniz (1646-1716) al intentar identificar un sistema apropiado de tales parcelas, y para ello construyó un lenguaje lógico. En los años de 1960 Alan Newell y Herbert Simon recogieron estas ideas y crearon un programa simbólico, destinado a resolver teoremas y jugar ajedrez, si bien incapaz aún de enfrentar problemas de la vida real.

¿En qué consiste el enfoque de arriba hacia abajo? Para muchos investigadores las neurociencias que se desarrollaron entre 1930 y 1950 demostraron que era factible estudiar fenómenos complicados en sistemas relativamente sencillos. Se comenzó a hablar de “mecanismos” de transmisión sináptica, es decir, la manera eléctrica, química y física como se comunican entre sí las células nerviosas, llamadas neuronas, así como con otros sistemas del cuerpo (por ejemplo, el corazón y los pulmones). Algunos se han propuesto darle vida autónoma a un robot con atribuciones de inteligencia humana, y pretenden hacerlo construyendo, primero, un cerebro que luego controle sistemas semejantes al oído, la vista y el movimiento tanto de animales como de humanos.

Desde 2017 existen diversos dispositivos antropomórficos muy realistas, pues responden al auge de dos factores en el cómputo de fines del siglo XX e inicios del XXI. Uno, la miniaturización de los componentes electrónicos y eléctricos; dos, la velocidad de los procesadores aunado a la capacidad de memoria y almacenamiento de datos. Desde luego, todo esto impulsado por los novedosos materiales plásticos y cerámicos que otorgan a estos muñecos parlantes una nueva calidad de realismo intimidante.

Con el propósito de mejorar su modelo de inteligencia, estudiosos de la IA empezaron a ocuparse de la Psicología cognoscitiva, disciplina que aborda la forma de percibir y pensar que distingue a los seres humanos. Después comprobaron sus teorías programando las computadoras a fin de simular los procesos cognoscitivos en el modelo. Otros investigadores del siglo XX intentaron obtener teorías generales de la inteligencia que fueran aplicables a cualquier sistema de inteligencia y no se limitaran al del ser humano. Buscaban una técnica universal para la solución de problemas. Esto se encuentra en el meollo de la IAG.

Semejante intento a gran escala ha sido abandonado y las investigaciones actuales se orientan al diseño de programas capaces de imitar los procesos de toma de decisiones de expertos, como médicos y químicos. Contienen bases de datos con los conocimientos de especialistas en cada materia y se utilizan para diagnosticar enfermedades, identificar moléculas químicas, localizar yacimientos de minerales e incluso diseñar sistemas de fabricación. Las investigaciones alrededor de la percepción se aplican en robots capaces de “ver”. Se piensa que, al cabo del tiempo, por este camino se obtendrá un sistema capaz de reproducir todas las facetas de la inteligencia humana.

Avances en neurofisiología propuestos por Warren McCulloch y Walter Pitts, así como aportaciones en el estudio detallado de las vías de las neuronas para comunicarse y la actividad química involucrada a partir del trabajo de Pablo Rudomín y colaboradores, alentaron la búsqueda de nuevas soluciones a los problemas de la IAG. Una minuciosa investigación cuasi hipermodernista durante décadas estaba teniendo consecuencias en una disciplina aparentemente dispar y muy alejada. Se consolidó el concepto de “red neuronal” con el propósito de emular en una máquina la capacidad humana de memorizar y asociar hechos.

Conocer implica pensar

Como se dijo antes, en los años de 1960 Alan Newell y Herbert Simon se inspiraron en estas ideas y crearon un programa simbólico, destinado a resolver teoremas y jugar ajedrez, pero incapaz aún de enfrentar problemas de la vida real. ¿Por qué ha sido tan útil este juego de mesa como metáfora de la IA? Porque la cantidad de movimientos probables excede el número de átomos en el Universo, según el campeón Garry Kasparov, el primer gran maestro en ser derrotado por una máquina, Deep Blue, en 1987.

De hecho, los programas que juegan ajedrez no pierden el tiempo en esta clase de búsqueda titánica. En cambio, pronostican lo que sucederá en el corto plazo. Usando cálculos matemáticos, determinan las posibles ventajas de su posición en el tablero, clasifican tales posiciones intermedias y eligen la más conveniente. Sus reglas tácticas, heurísticas, las encontramos en todos los sistemas de IA, como un auxiliar extremo de otros métodos más meticulosos, precisos y dilatados. Sin embargo, las computadoras jugadoras de ajedrez no contribuyeron en forma significativa al avance de la cognición mecanizada. Deep Blue triunfó usando no su inteligencia, sino la fuerza bruta en el procesamiento de datos.

Las propuestas cibernéticas empujaron las ideas milenarias de dotar de inteligencia a las máquinas. Pero, ¿cómo debía procederse? ¿Había que ir de arriba hacia abajo, construir primero un cerebro, lo más complejo posible, para luego dotarlo de movilidad, enseñarle a moverse y realizar tareas específicas? O bien, por el contrario, ir de abajo hacia arriba, es decir, ¿es necesario primero construir partes simples, las cuales, con el tiempo y su interacción, evolucionarán y proporcionarán propiedades emergentes, hasta crear entidades inteligentes y sensibles, autónomas y emprendedoras? La IA tradicional intentó, con resultados magros, ensayar la primera alternativa. La nueva IAG privilegia esta segunda ruta.

El auge de las matemáticas en el siglo XVII fue un factor decisivo en el desarrollo inicial de esta metáfora, pues está íntimamente ligada a la concepción del fenómeno de la vida como una máquina computacional. Blaise Pascal (1623-1662) dio el primer paso cuando inventó la máquina calculadora digital. Llamada “la pascalina”, era capaz de sumar hasta ocho dígitos por medio de un mecanismo de ruedas dentadas. El matemático alemán W. G. Leibniz también se sintió atraído por estos aparatos e intentó diseñar una máquina capaz de sumar, restar, multiplicar y dividir. El éxito de su invento puso de manifiesto la enorme capacidad de abstracción matemática y realización práctica que ya existía en ese entonces. Sin embargo, ninguna de estas máquinas podían programarse para llevar a cabo operaciones simultáneas y se limitaban a realizar una en cada paso.

No fue sino hasta que el ingeniero inglés Charles Babbage (1791-1871) apareció con sus conceptos revolucionarios que comenzó a allanarse el camino hacia una verdadera computación inteligente, encaminada a relacionar organismos vivos e ingenios automatizados. No es posible olvidar la aportación fundamental de su socia en este proyecto, Ada Lovelace (1815-1852), quien escribió los primeros compiladores utilizando algoritmos. Un algoritmo es una serie de instrucciones o pasos que sirven para llevar a cabo una tarea u objetivo y resolver un problema. Debido a su naturaleza matemática, un algoritmo bien desarrollado debe guiarnos a encontrar la solución más eficaz. Así, un algoritmo, o bien, una combinación de varios, tienen la capacidad de resolver un problema matemático, en principio. Pero también, desde 1840, se demostró que los algoritmos más refinados pueden resolver algunos problemas del mundo real, en particular, el funcionamiento de los organismos vivos.